El análisis de datos agrupados es una parte fundamental de la probabilidad y la estadística, y la optimización de parámetros en este contexto es crucial para obtener resultados significativos y avanzar en la comprensión de los fenómenos que se estudian. En este artículo, exploraremos los pasos clave para optimizar los parámetros en el análisis de datos agrupados, centrándonos en la importancia de este proceso y las técnicas que se pueden emplear para alcanzar resultados óptimos.

Definición de parámetros en el análisis de datos agrupados

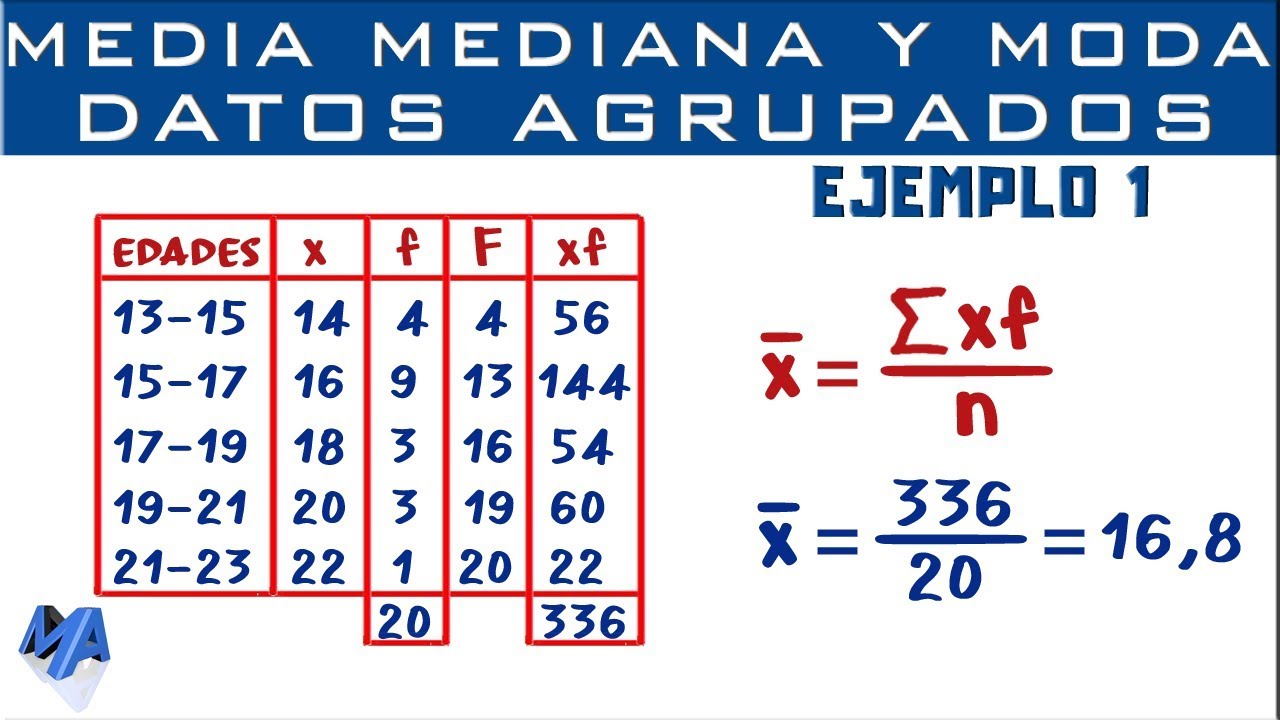

Antes de adentrarnos en las estrategias de optimización, es importante comprender qué son los parámetros en el contexto del análisis de datos agrupados. Los parámetros se refieren a las características numéricas que describen una población o una distribución de datos, como la media, la varianza y la desviación estándar. Estos parámetros son fundamentales para comprender el comportamiento de los datos y extraer conclusiones significativas a partir de ellos.

Importancia de la optimización de parámetros

La optimización de parámetros en el análisis de datos agrupados es esencial para garantizar que los modelos estadísticos y las inferencias realizadas a partir de los datos sean precisos y confiables. Al ajustar los parámetros de manera óptima, se puede minimizar el error y obtener estimaciones más certeras, lo que a su vez conduce a una mejor comprensión de los fenómenos estudiados.

Técnicas comunes de optimización

Existen varias técnicas que se emplean para optimizar los parámetros en el análisis de datos agrupados. Estas incluyen métodos de estimación de máxima verosimilitud, técnicas de minimización de errores cuadráticos, y algoritmos de optimización numérica, entre otros. Cada una de estas técnicas tiene sus propias ventajas y aplicaciones específicas, y la elección de la técnica adecuada dependerá de la naturaleza de los datos y el problema en cuestión.

Preparación de los datos para optimización

Antes de iniciar el proceso de optimización de parámetros, es crucial realizar una preparación adecuada de los datos. Esto incluye la limpieza de datos, la identificación de posibles sesgos o anomalías, y la selección de un modelo apropiado que refleje la distribución subyacente de los datos. La calidad de los resultados de la optimización dependerá en gran medida de la calidad de los datos y el modelo seleccionado, por lo que dedicar tiempo a esta etapa es fundamental.

Limpieza y preprocesamiento de datos

La limpieza de datos involucra la identificación y corrección de valores atípicos, eliminación de datos faltantes, y asegurar que los datos estén en el formato adecuado para el análisis. El preprocesamiento de datos puede incluir la normalización de variables, la transformación de datos según sea necesario, y la división adecuada de los conjuntos de datos en entrenamiento y prueba. Este paso es esencial para garantizar que los datos estén listos para la optimización de parámetros.

Selección del modelo apropiado

Antes de optimizar los parámetros, es fundamental seleccionar un modelo estadístico o de probabilidad que se ajuste de manera adecuada a los datos. Esto puede implicar la elección de una distribución de probabilidad específica, la selección de variables explicativas relevantes, y la consideración de la complejidad del modelo. Un modelo inapropiado puede llevar a optimizaciones erróneas, por lo que esta etapa es crucial en el proceso.

Proceso de optimización de parámetros

Una vez que los datos estén preparados y el modelo haya sido seleccionado, se puede proceder con el proceso de optimización de parámetros. Este proceso involucra ajustar los parámetros del modelo de manera que se minimice la diferencia entre las observaciones reales y las predicciones del modelo. A continuación, se detallan los pasos clave en este proceso.

Estimación de máxima verosimilitud

La estimación de máxima verosimilitud es una técnica ampliamente utilizada para optimizar los parámetros de un modelo estadístico. Consiste en encontrar los valores de los parámetros que maximizan la verosimilitud de que los datos observados hayan sido generados por el modelo propuesto. Esta técnica es especialmente útil en la optimización de parámetros para distribuciones de probabilidad.

Minimización de errores cuadráticos

Otra técnica común para la optimización de parámetros es la minimización de errores cuadráticos. Este enfoque busca ajustar los parámetros del modelo de manera que se minimice la suma de los cuadrados de las diferencias entre las observaciones reales y las predicciones del modelo. Esta técnica es ampliamente utilizada en la regresión lineal y otros modelos que buscan minimizar el error de predicción.

Algoritmos de optimización numérica

Además de las técnicas mencionadas, existen numerosos algoritmos de optimización numérica que pueden ser empleados para encontrar los valores óptimos de los parámetros. Estos algoritmos incluyen el descenso de gradiente, algoritmos genéticos, y métodos de búsqueda aleatoria, entre otros. La elección del algoritmo dependerá de la complejidad del modelo y la naturaleza de los datos a optimizar.

Evaluación de la optimización

Una vez que se han ajustado los parámetros del modelo, es crucial evaluar la calidad de la optimización y los resultados obtenidos. Esto implica la realización de pruebas de rendimiento, la comparación de las predicciones del modelo con los datos reales, y la consideración de métricas de ajuste como el coeficiente de determinación y el error cuadrático medio.

Pruebas de rendimiento

Realizar pruebas de rendimiento del modelo optimizado es fundamental para comprender su capacidad predictiva. Esto puede involucrar la evaluación del modelo en datos de prueba no utilizados en la optimización, así como la comparación con otros modelos existentes o baselines establecidos. Las pruebas de rendimiento pueden revelar posibles áreas de mejora o indicar la validez de los resultados obtenidos.

Comparación de predicciones

Comparar las predicciones del modelo optimizado con los datos reales es un paso crucial para evaluar la calidad de la optimización. La discrepancia entre las predicciones y las observaciones puede proporcionar información sobre la precisión del modelo, así como identificar posibles áreas de sesgo o error en la optimización de parámetros.

Consideraciones adicionales

Además de los pasos mencionados, existen varias consideraciones adicionales que deben tenerse en cuenta al optimizar los parámetros en el análisis de datos agrupados. Estas incluyen la selección de métricas de evaluación apropiadas, la validación cruzada para evitar el sobreajuste, y la interpretación apropiada de los resultados obtenidos. La optimización de parámetros es un proceso complejo que requiere atención a múltiples factores para asegurar resultados sólidos y significativos.

Selección de métricas de evaluación

Es fundamental seleccionar métricas de evaluación apropiadas para medir la calidad del modelo optimizado. Estas métricas pueden incluir el error cuadrático medio, el coeficiente de determinación, el área bajo la curva ROC, entre otros. La elección de métricas adecuadas dependerá del problema específico y los objetivos del análisis.

Validación cruzada

La validación cruzada es una técnica importante para evitar el sobreajuste del modelo durante la optimización de parámetros. Consiste en dividir los datos en múltiples subconjuntos, ajustar el modelo en una parte de los datos y evaluar su rendimiento en el resto, repitiendo este proceso varias veces. La validación cruzada ayuda a garantizar que el modelo no esté sobreajustado a los datos de entrenamiento y sea capaz de generalizar a nuevos datos.

La optimización de parámetros en el análisis de datos agrupados es un proceso fundamental para obtener resultados precisos y confiables en el ámbito de la probabilidad y la estadística. Al seguir las técnicas adecuadas de preparación de datos, selección de modelo y optimización de parámetros, es posible avanzar en la comprensión de fenómenos diversos y realizar inferencias significativas a partir de los datos disponibles. La optimización de parámetros es un área en constante evolución, con nuevas técnicas y enfoques que continúan enriqueciendo la práctica de la ciencia de datos y la estadística aplicada.